惡意AI模型潛伏Hugging Face,駭客陰謀大揭秘

- 發布單位:TWCERT/CC

- 更新日期:2025-03-20

- 點閱次數:23894

Hugging Face成立於2016年,是全球AI領域最重要的開源平台,以豐富AI模型和資料庫聞名。近期ReversingLabs(RL)的威脅研究團隊發現Hugging Face平台上存在惡意機器學習模型,這些模型利用Python的Pickle檔案序列化漏洞執行惡意程式碼,並將其隱藏在模型中。然而Hugging Face的安全掃描機制並未將其標記為「不安全」,研究人員將這種傳播技術命名為「nullifAI」,引發了對AI模型安全性的廣泛注意。

Pickle是python的一個標準函式庫,主要用於序列化和反序列化Python物件結構,特別在機器學習模型的資料儲存和傳輸中方便使用。雖然Pickle易於使用,但它常見的序列化漏洞風險使得攻擊者可透過Pickle將惡意程式碼隱藏在模型中。Hugging Face官方特別提醒使用Pickle時,應格外注意資安風險,並將Pickle序列化的問題稱為「Pickling」。

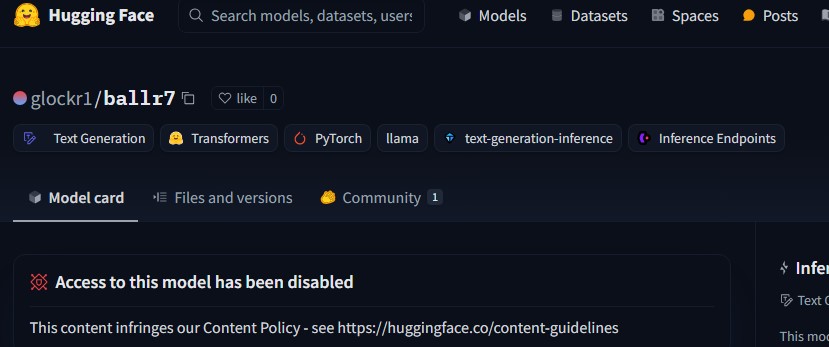

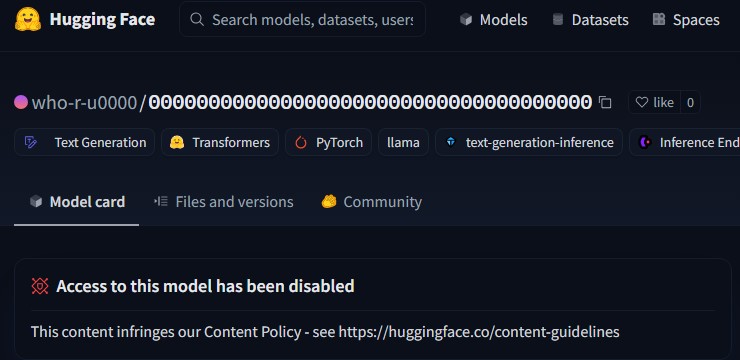

Hugging Face平台提供名為「picklescan」的掃描工具,專門用於檢測惡意的Pickle檔案。不過該工具僅能掃描完整、未損壞的Pickle檔案,因此駭客利用「損壞」Pickle檔案的技術規避安全檢測,這些損壞的檔案在反序列化時會出現錯誤,但不影響執行惡意程式碼。圖1和圖2是ReversingLabs威脅研究團隊發現的惡意AI模型,目前已被Hugging Face平台關閉。

圖1: 在Hugging Face上的惡意AI模型。

圖2: 在Hugging Face上的惡意AI模型。

駭客建構的AI模型使用壓縮格式的Pickle檔案,檔案的前半段包含惡意程式碼,後半段則是無效或損壞的資料。在解序列化的過程中,由於檔案逐步被處理,因此位於前半段的惡意程式碼會先被成功執行,由於後半段的資料損毀,反序列化過程中出現錯誤並終止執行。由於picklescan僅能掃描完整、未損壞的Pickle檔案,因此無法識別此AI模型是惡意的Pickle檔案。

2025年1月20日,ReversingLabs向Hugging Face通報該平台上發現惡意AI模型與工具漏洞。Hugging Face團隊於24小時內移除惡意模型,並將picklescan進行更新,以加強「損壞」的Pickle檔案的偵測能力。

針對使用開源AI模型的防禦建議如下:

1.

開發團隊在使用 Hugging Face 等平台上的機器學習模型時,應格外小心 Pickle檔案。

2.

建議避免使用Pickle檔案格式,改用其他較安全的序列化檔案格式。

3. 確保任何載入AI模型所需的自訂操作與序列化的模型資料分開。

惡意AI模型的IoC:

l 1733506c584dd6801accf7f58dc92a4a1285db1f

l 79601f536b1b351c695507bf37236139f42201b0

l 0dcc38fc90eca38810805bb03b9f6bb44945bbc0

l 85c898c5db096635a21a9e8b5be0a58648205b47

l 107.173.7.141